Slay the Spire その14 アセンションモード20Hをウォッチャーでクリア

2025-12-11 10:51:44

- Tags:

- ゲーム

- Slay the Spire

前回2日前にディフェクトでクリアって書いたけど、

数日でウォッチャーもクリア!

時間かかるだろうなって思ってただけにあっさりクリアしてしまって、これでいいの?って感じ。

いやー、シード値がかなり上振れしたなー。

もう一回やれって言われてもできないレベル。

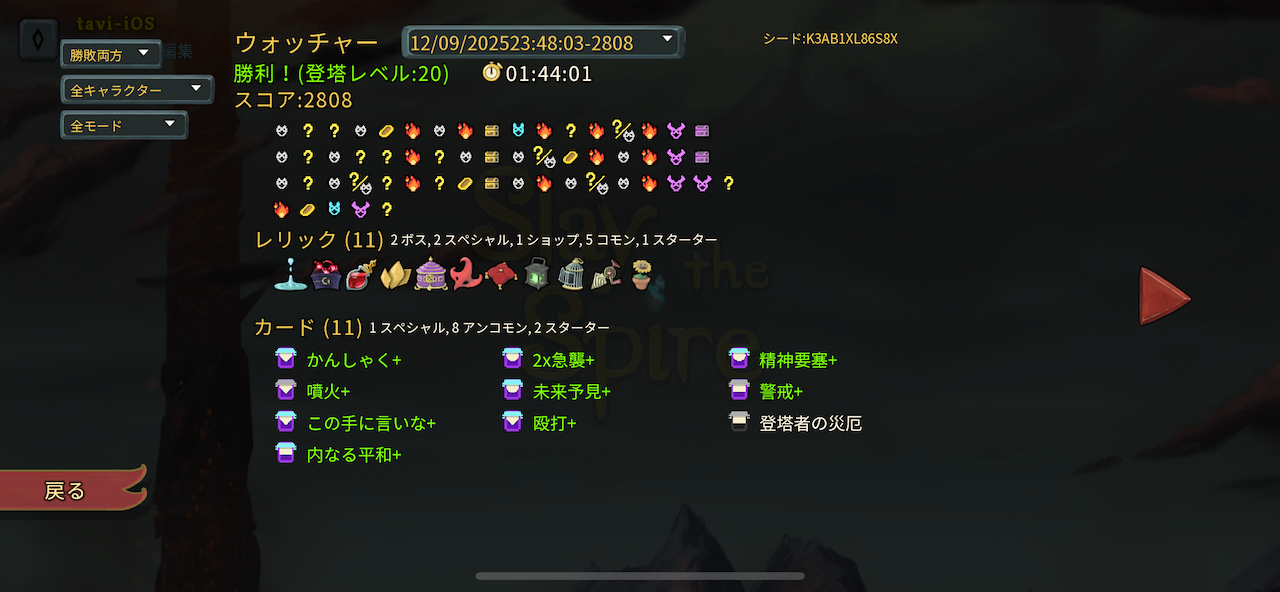

では、デッキ公開。

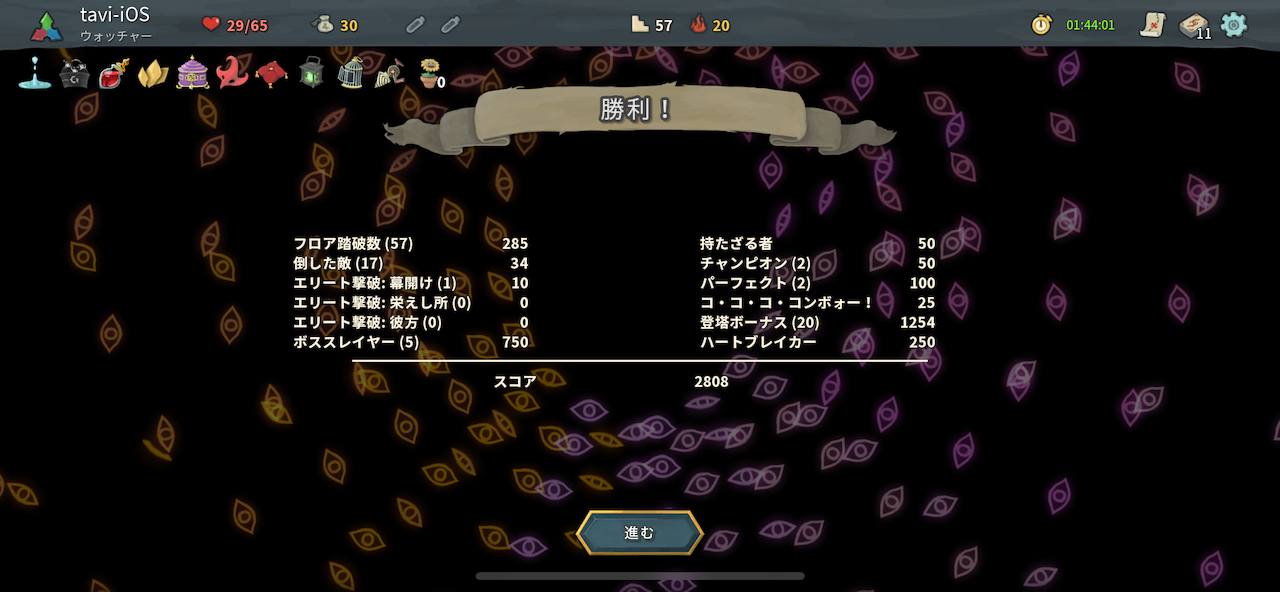

アセンション20H ウォッチャー

最高と言っていいほどの圧縮ループ。

以前A18をクリアしたときもかなり良い圧縮ループだったけど、今回はそれ以上。

Slay the Spire その08 アセンションモード18をクリア

全部UGでき、

かんしゃく、急襲2枚、精神要塞(不動心)、この手に言いな、内なる平和

というキーカードをしっかり含んでいる。

ストライクと防御もなくせたので、3層途中から内なる平和とかんしゃくをするだけの無限ループが完成。

最高に上振れしたわ。

ウォッチャーは最後のデッキだけを見ても途中の苦労を想像しづらいので時系列順に書いてみる。

まず最初のネオーボーナス。

この回の前の回で、Act1のボスにたどり着く前に倒されてしまったので、ネオーボーナスはHP1を3回を選んだ。

圧縮ウォッチャーを目指す場合、2枚もしくは1枚の変化が一番望ましいので、

この回はスタートは必ずしもよいわけではなかった。

それでも、なんとか初戦でかんしゃくがぴっくできたので、

強化エリートのボスグレムリンはなんとかギリギリ倒せた。

Act1の宝箱でもらったレリックも血の瓶という、ちょっと微妙に噛み合っていないレリックだった。

まあでもないよりよい。

良かったのは、ボス前に急襲が出たこと。

そして、ボスレリックがパンドラの箱だったこと。

これによりストライクと削除が全て変化でき、

しかもその中に、悪しきを恐れず、この手に言いな、精神要塞、殴打、未来予知、致命が入っていたこと。

致命は、憤怒状態にすると結構倒しやすいので、UGがガンガン進む。

Act2で急襲2枚目や、内なる平和も取れたので、他のいらないカードはどんどんスルーし、

削除も進めていけた。

赤仮面、ランタンなどの有用レリック、

ボスレリックで、空っぽの檻を取ることができて、

ここまで来るともう悪しきを恐れずがほとんど使ってなかったしUGも終わっていたので、

悩んだけど、致命と悪しきを恐れずを削除。

未来予知は最後まで悩みに悩んで、結局残した。

何故かというと、心臓や矛楯、タイムイーターなどでデッキが汚染されるのが分かっていたので、

無限ループができるようになるまでに、呪いカードで身動き取れなくなるという自体をさけたかったから。

結果この判断が心臓戦で一番功を奏したと思う。

殴打は割と好きなカード。

(他には、サイレントのダッシュとか、アイアンクラッドのアイアンウェーブとかも好き)

しかし、無限ループが完成するとほぼ使わないので、

どっちかというと、1,2ターンで大ダメージ与えてくるようの保険の意味が強くなった。

パワーや、この手に言いななどの一度使ったら消える系のカードが多いために、

デッキが1周すると、5枚にまで圧縮されていたので、無限ループが容易。

ここからはだいたい無限ループで倒した敵の最後の姿を載せていく。

無限ループ完成したあたりが下記。

だから消えゆくものも簡単に倒せる。

ここらへんからボス2連とAct4を見据えて、残しておきたいポーションを吟味する。

パワー系多いので心配していた、目覚めしものも楽勝。

難関と思われていたタイムイーター。

12枚で途切れてしまうので、無限ループはできなかったが、

精神要塞とこの手に言いなでブロックは積み上がるので、

他のカードで調整することで余裕で倒せた。

矛楯も、ポーション残したまま倒せた。

ここでもらえたのはハッピーフラワー。あって困るものではない。

さて、心臓戦。

初手は必ずしも良くないが、パワー3種唱えられたのはよい。

しかも心臓戦の第1行動は必ずデッキ汚染なので、大ダメージ喰らわなくて済むし。

2ターン目も67ダメージをブロックとHPでなんとかやり過ごして、3ターン目でようやく無限ループへ。

ここからは毎ターンのダメージ上限までダメージを与えていくので、特に難しくもなし。

そして最後。

こんなに余裕をもって倒せたのは初めてではないかな。

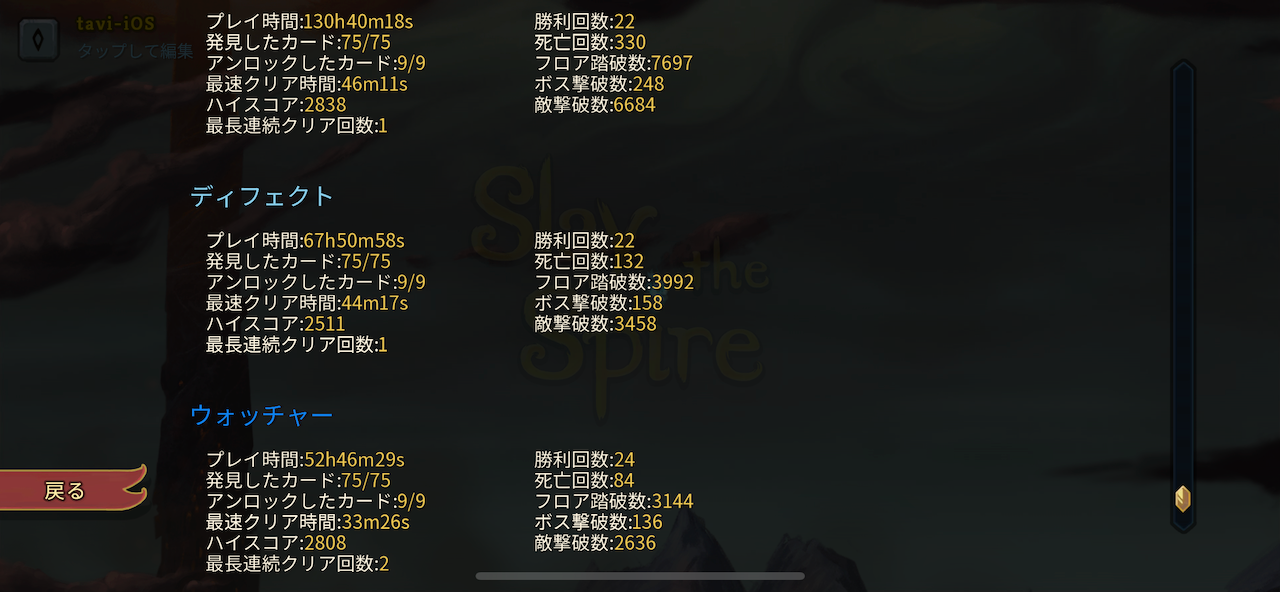

さて、時間比較。

アイアンクラッドを抜いて、ウォッチャーが1番少ない時間でクリアできた!

いやー、そこまで得意じゃないんだけどね。ハマると強いな。

さて、なんとかSlay the Spire 2が出る前に、A20Hを全クラスで倒せた!

よかったー。

残りは実績埋め。

Switch版では一度やったことあるが、コモンセンスとか、ミニマリストとか。

レベル0に戻るので、非常に楽に思えるでしょう。

だけど、ただ面倒なだけの実績もあるからなー。